- 簡単かつ安く高精度なアンテナアナライザーを自作したい | tech - 氾濫原

- 簡単かつ安く高精度なアンテナアナライザーを自作したい (2) | tech - 氾濫原

- 自作アンテナアナライザーのBluetooth化とアプリケーション | tech - 氾濫原

あたりの続きです。

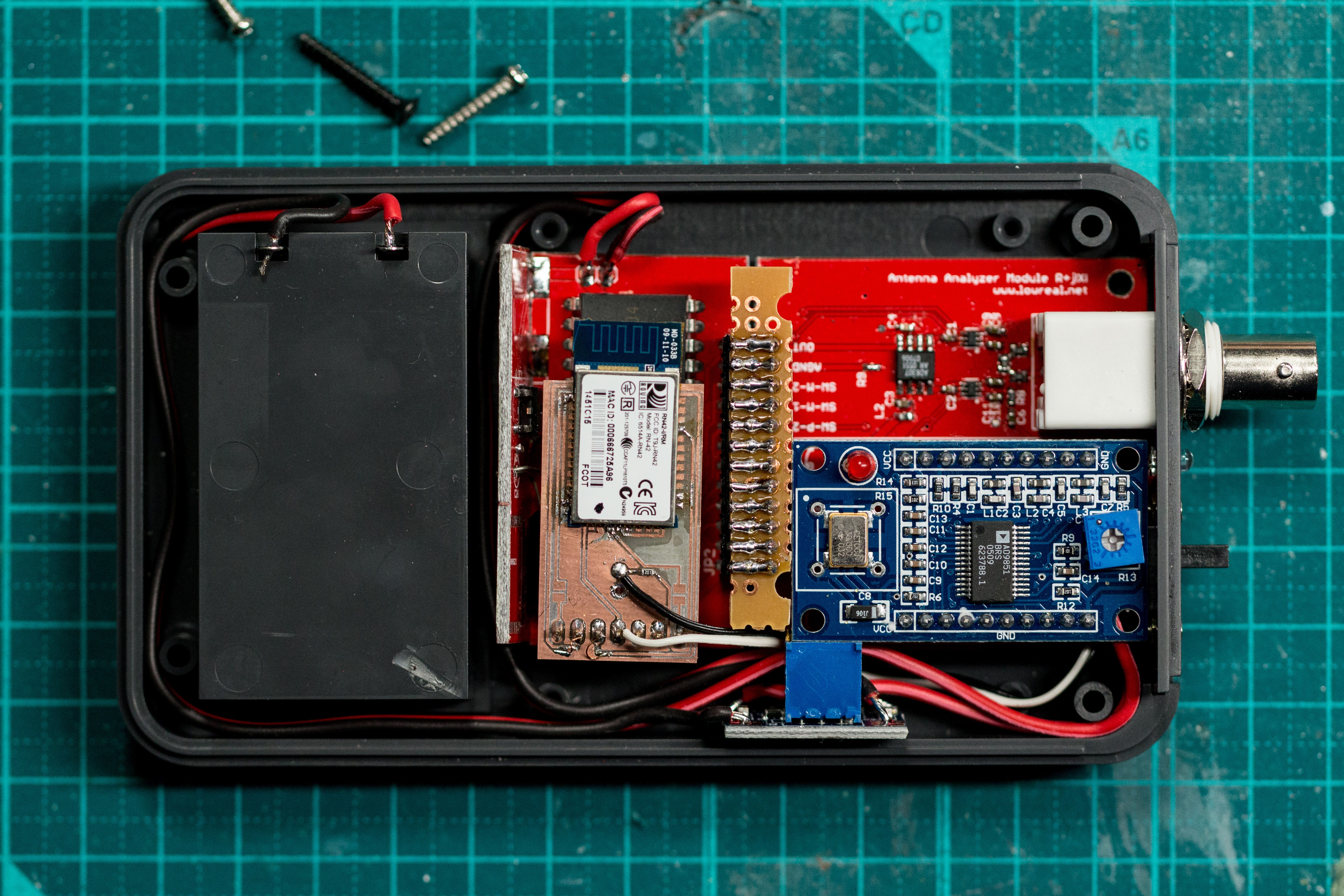

ちょっと飽きてきたというか疲れてきたので、とりあえず使えるレベルを目指すという意味でケースに収めることを優先することにしました。

発注した基板そのままでは収めることができなかったので、いろいろ試行錯誤して収めました。本来基板を設計する段階でケースまで決めてしまえればいいんですが、今回そこまで気をまわすことができませんでした。おかげでだいぶ苦労しましたがなんとか入りました。

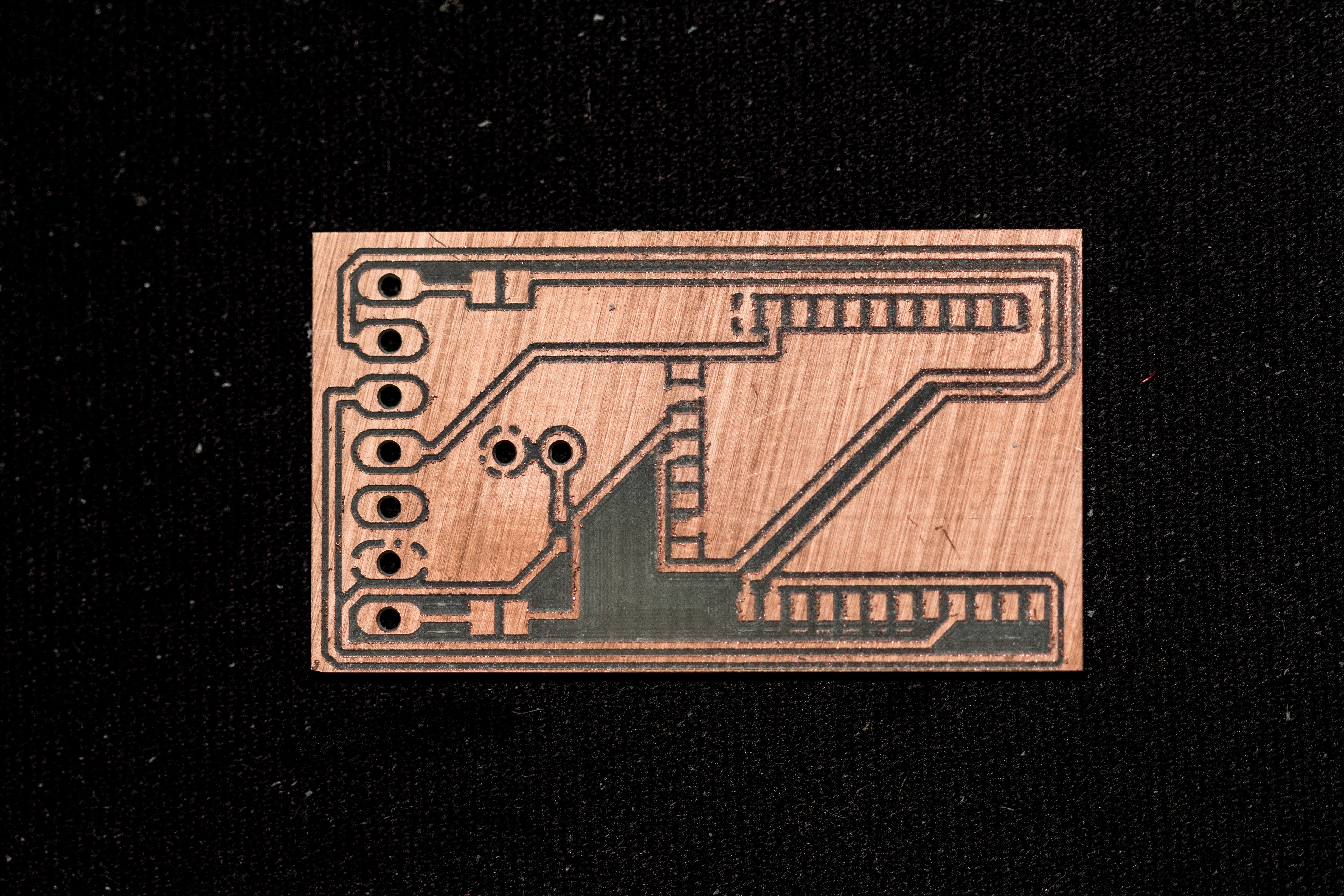

Bluetooth モジュール用基板

Bluetooth モジュールは別途基板を自分で掘って載せるようにしました。場所がないので2階建です。

切削はそこそこ上手くいったのですが、ほとんど肉眼で確認できないのにGNDと導通があったり、実際実装してみると見えない部分で半田がショートしたりと、なかなか厳しい状態になりました。3回ぐらいモジュールの半田づけをやりなおしたのでパターンが剥れたり、ついでに勘違いからRX/TXが逆配線になっていると思ってリワークまでしたけど元々の配線であってたり、、、みたいないろんな思い出があります。

ケースの加工

CNC でやりましたが、プラスチック(ABS) の加工はものすごく苦手意識があります。アルミと違ってプラスチックは溶けるので早く動かしすぎてもダメだし遅く動かしすぎてもダメだしで「安全方向にふる」という運用が通用しないのです。

今回は以下ぐらいでやるとすくなくともエンドミルに溶けたプラスチックが固着して折れるということはなくなりました…… (2本折りました)

- φ1mm 2枚刃 エンドミル

- F500 (割と早い) Z送り50 (かなり遅い)

- 回転数 50% 約5000rpm

- S500 指定だが、最大1000を最大の電圧として500だけ電圧をかけるという意味で、500は回転数ではない (最大の50%の回転)

タコメータをつけてないので回転数が正確にわかってません。

インターフェイス

見ての通りですがインターフェイス的には

- 電源スイッチ

- LED (Bluetooth の接続状況: 接続待ちは点滅・接続済みは点灯)

- BNC コネクタ

しかありません。これは最初からこうするつもりで作っていて、Bluetooth 経由で接続したスマートフォンから全ての操作を行うという設計です。

というのも、アナライザを作るなら、まず絶対に Bluetooth などで無線化したいという思いがありました。なぜかといえば、実際にフィールドでアンテナの調整を行う場合、給電点と調整点というのは必ずしも一致しておらず、既存のアンテナアナライザーだと給電点と調整点をいったりきたりする必要があって面倒だからです。例えば7MHz帯の半波長逆Vダイポールをフィールドで一時的に立てようと思うと、給電点と調整点では10mぐらいの距離があってしんどいのです。

今後

これでとりあえず使えるぐらいにはなりました。しかし、かなり問題があります。

- Android 側のアプリケーションの完成度がいまいちなのをなんとかする

- ソフトウェアだけなのでおいおい

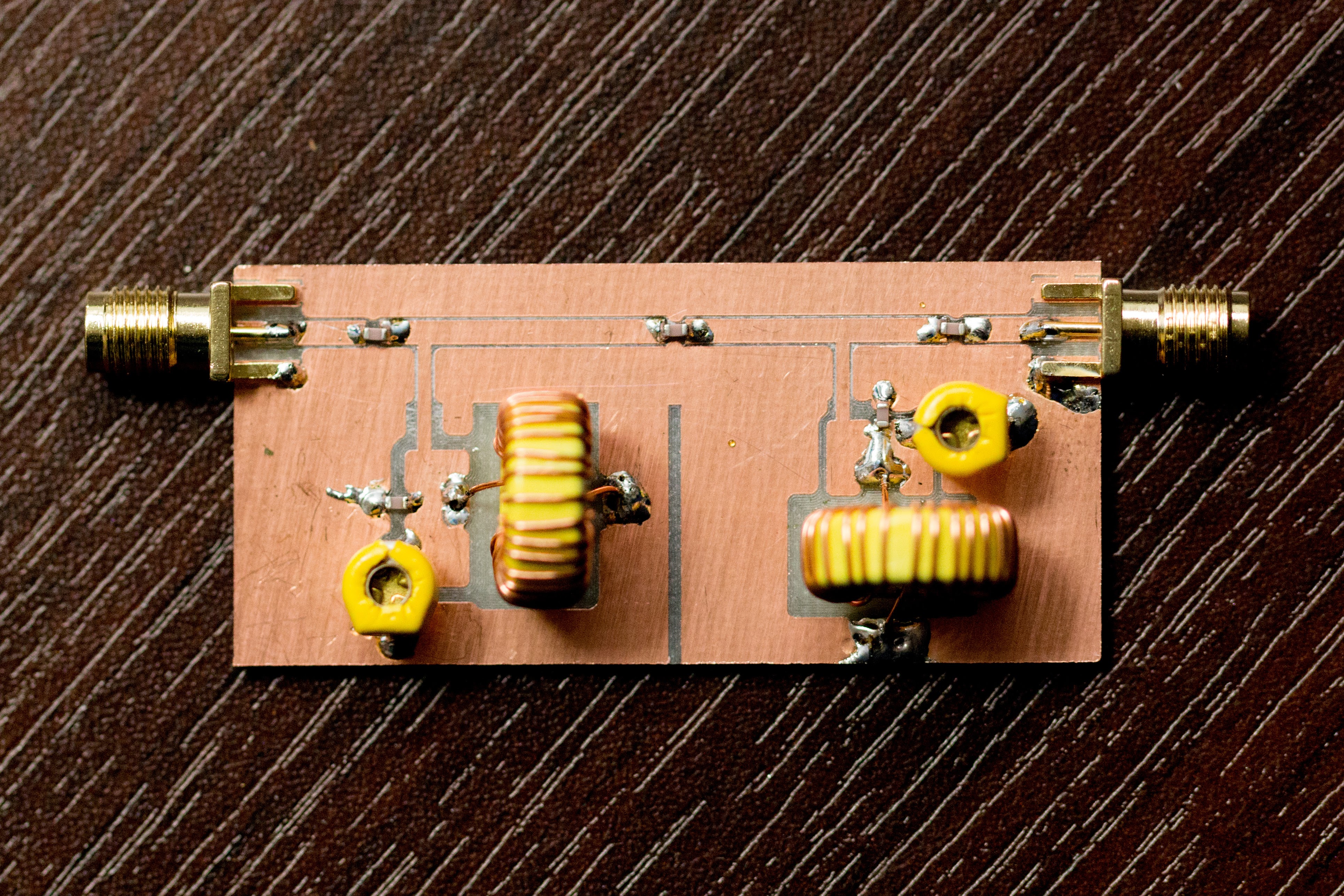

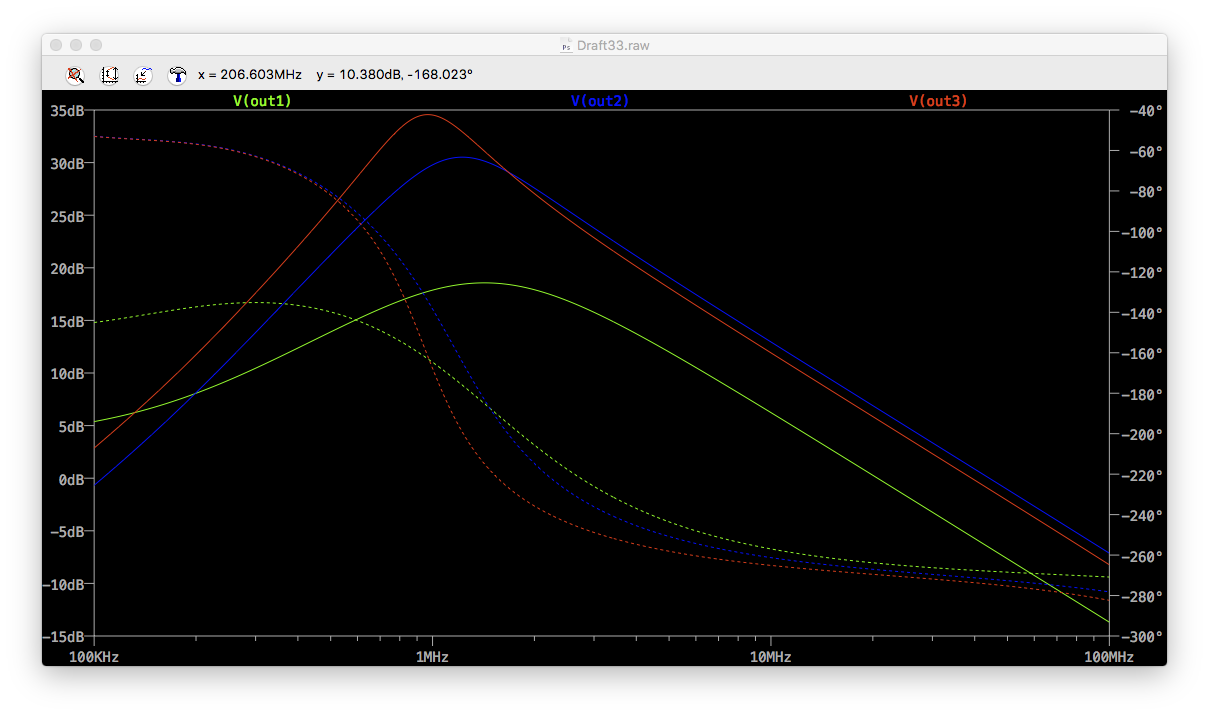

- インピーダンスのグラフが波うつ

- どっかで反射の影響が起きていると思うけどどこかわかってない

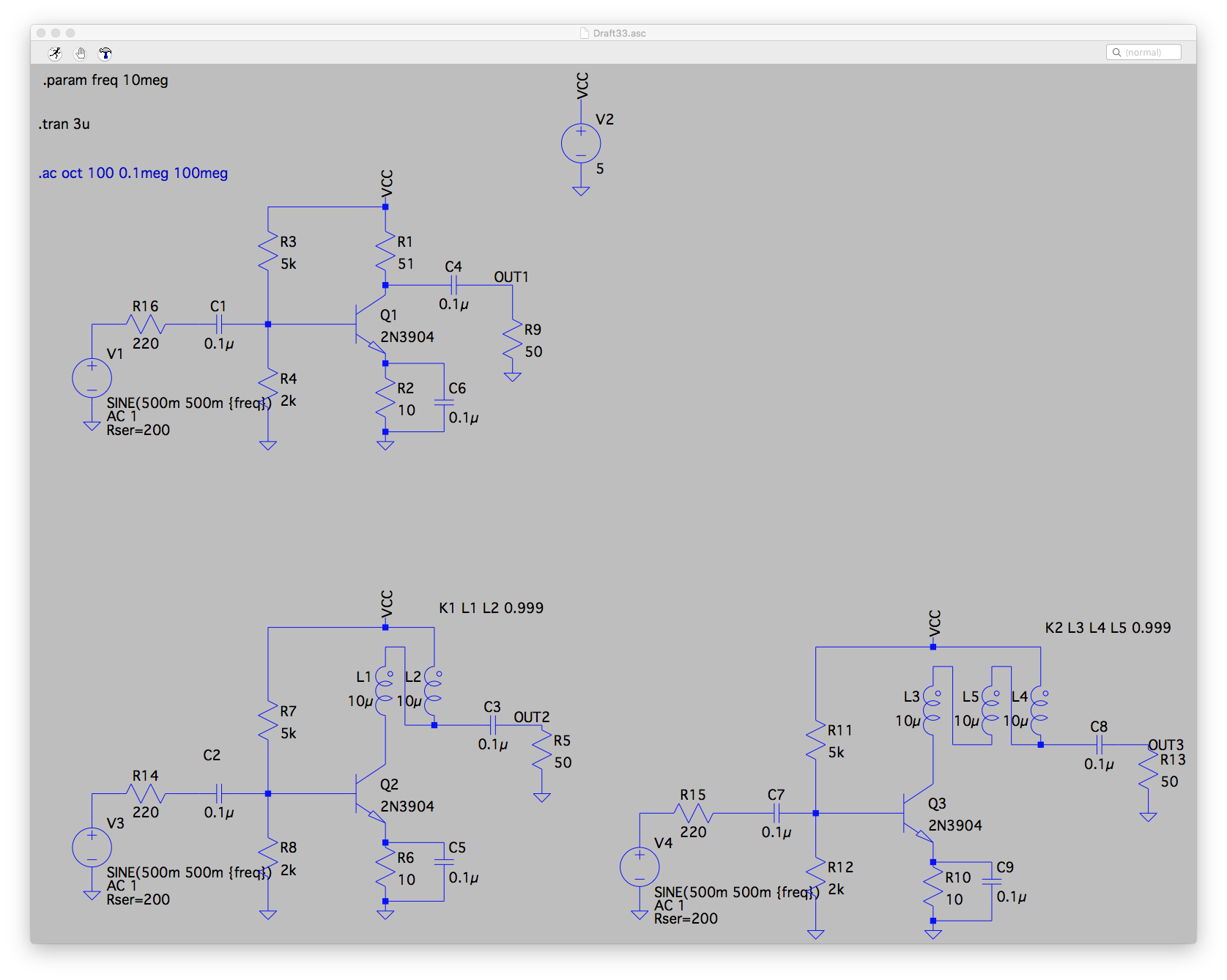

- RFアンプの設計からやりなおす

- というか面倒なのでMMIC使うとか

- 低消費電力化

- RFアンプに常時電源供給してしまっているのをやめる

- RFアンプの再設計

- AD9851 と Bluetooth デバイスの消費電力がデカいのでできることは限られる

- ケースに組みこんだら計測にノイズが乗るようになった

- NiMH 2本を電源にしたいと拘ったため、DC/DC で 5V まで昇圧しているが間違いなくノイズ源になっている

- Bluetooth モジュールとADC部が近い

- もっと小さく作りたい

- MCU が無駄にでかい

単三電池2本の電源内蔵するのも今回なぜかこだわっていたのですが、どうせDC/DCで昇圧するならモバイルバッテリ使えるようにして、電池は内蔵しないほうがコンパクトかつ総合的には荷物が減って良さそうです。

![ガールズ&パンツァー 劇場版 [Blu-ray] - 渕上舞](https://m.media-amazon.com/images/I/61QuPEjbaOL._SL500_.jpg)